Tenk på Google News. Da tjenesten ble lansert i 2002 var den et av de første forsøkene på å samle inn og personalisere nyheter med algoritmer — det vil si med prosedyrer som skritt for skritt og systematisk behandler informasjon. Google skrøt til og med av det på hjemmesiden: “Denne siden ble laget utelukkende med datamaskinalgoritmer, uten menneskelige redaktører. Mennesker ble verken skadet eller brukt i arbeidet med denne siden.”

Google News-algoritmens kriterier for å rangere og gruppere nyhetsartikler er publiseringshyppighet, kilde, aktualitet, sted, relevans og mangfold. Millioner av ganger om dagen bruker Google News-algoritmen disse kriteriene til å ta redaksjonelle avgjørelser.

Likevel, i den systematiske bruken av beslutningskriterier kan algoritmen skape skjevheter som ikke synes opplagte, gitt programmeringen av den. Det kan være lett å gi etter for feilslutningen om at fordi datamaskinalgoritmer er systematiske, så må de på et vis være mer “objektive”. Men det er faktisk slike systematiske skjevheter som er de mest lumske, siden de ofte går ubemerket hen.

Selv roboter kan være partiske.

Enhver beslutningsprosess, enten menneskelig eller algoritmisk, om hva som skal tas med, ekskluderes eller vektlegges — prosesser Google News har mange av — har potensial til å skape skjevheter. Det interessante med algoritmer er at beslutningskriteriene som er tilgjengelige for algoritmen kan synes harmløse, men samtidig føre til resultater som oppleves som partiske eller med slagside.

Enhver skjevhet i dataene som algoritmen fores med blir med på lasset

Et eksempel: Hvis den ikke programmeres spesielt for det, vil ikke Google News-algoritmen ta parti når den plukker representative artikler om en lokal valgkamp — tjenesten er grunnleggende upartisk. Men et av kriteriene for å velge ut artikler er “publiseringsfrekvens”. Det kan virke nøytralt — men hvis en av kandidatene i valgkampen gjennomgående får litt mer mediedekning (altså høyere “publiseringsfrekvens”), kan det kriteriet få Google News’ utvalg til å virke partisk.

Algoritmer kan mangle semantisk grunnlag til å kunne forstå mer avanserte begreper som stereotypier eller rasisme. Hvis de enkle og målbare kriteriene algoritmene bruker til å ekskludere informasjon fra synlighet på en eller annen måte korrelerer med for eksempel kløfter mellom folkegrupper, kan de se ut som at de har en slagside mot en folkegruppe.

Enkle beslutningskriterier som leder til komplekse avgjørelser om å inkludere og ekskludere er en måte som partiskhet og skjevhet, ofte uforvarende, kan vise seg i algoritmer. Andre mekanismer som kan skape skjevheter i nyhetsdekningen kan illustreres med en særlig viktig informasjonsprosess — oppsummeringen.

Oppsummering av virkeligheten

På en måte dreier nyhetsrapportering seg egentlig om å oppsummere virkeligheten. Du kan innvende: “Det dreier seg også om å fortelle en historie!” — og det vil du ha rett i, siden lite er kjedeligere enn en tørr oppsummering. Men før historien kan fortelles må reporteren ta beslutninger om hvilke hendelser som skal tas med, hva slags bakgrunnsinformasjon som trygt kan utelates, og hva som bør vektlegges som virkelig viktig. Alt dette har potensial til å farge historien. Reportere observerer verden og avdekker mye informasjon, for så å gjøre et håndterbart utvalg som er tilpasset tiden og oppmerksomheten publikum har til rådighet. Dette er å oppsummere.

Oppsummering er viktig fordi tid og oppmerksomhet er to av råvarene som definerer vår epoke. Mange av oss ønsker eller trenger ikke kjenne til intrikate detaljer i hver nyhetssak; ofte nøyer vi oss gjerne med et kjapt overblikk over en hendelse. Dette behovet for å optimere oppmerksomhet og redde oss fra informasjonsflommen driver fram nyskaping innen behandling og oppsummering av informasjon, i redaksjonelle vurderinger så vel som i nye datamaskinalgoritmer.

Gründerbedriften Circa i San Francisco arbeider med en app for redaksjonelle vurderinger som oppsummerer hendelser som serier av “punkter” eller faktabiter. Redaktører samler inn “fakta fra et mangfold av kilder” og gjør dem om til “konsise, lettleste “punkter” i Circa”, slik appens hjelpesider beskriver konseptet. Nå legger Circa selv mindre vekt på oppsummering og mer på historiefortelling. De knytter de konsise “punktene” sammen i en sekvens som bygger en historie. Tilnærmingen deres er drevet av redaktører og er selvfølgelig utsatt for alle de ulike måtene som skjevhet og partiskhet kan oppstå i en redigeringsprosess, inkludert både individuelle og organisatoriske preferanser.

Din daglige nyhetsmeny har antakelig blitt påvirket av mange ulike algoritmer

Men hva om Circa begynte å bruke algoritmer som istedenfor å basere seg på redaktører, tok automatiske avgjørelser om hvilke punkter de skulle ta med eller utelate? Da kunne de begynne å likne mer på London-baserte Summly, som har en ny lese-app med “algoritme-genererte sammenfatninger fra hundrevis av kilder”. Summly velger de “viktigste” setningene fra en artikkel og presenterer disse som oppsummering. Men hvordan kan denne algoritmen begynne å lage skjevheter i historiene den produserer, for eksempel gjennom definisjonen av “viktig”? Er det for eksempel tenkelig at algoritmen i en sak om den israelsk-palestinske konflikten kunne velge ut setninger på en disproporsjonal måte slik at den ene sidens syn vektlegges tyngre enn den andres?

Kanskje vil vi aldri få vite hvordan Summlys algoritmer kan skape skjevheter i oppsummeringene den lager; den er en proprietær og lukket teknologi. Det understreker behovet for åpenhet om algoritmer. Ved å studere mer åpne forsøk som forskningsbaserte prosjekter kan vi lære mye om hvordan algoritmer for oppsummering virker og kan skape skjevheter.

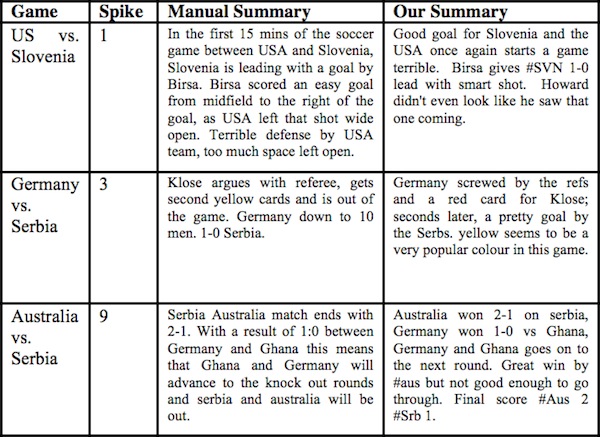

Jeg snakket med Jeff Nichols ved IBM Research, som har bygget et system (pdf) for å oppsummere sportsarrangementer basert kun på Twitter-meldinger (tweets) folk skriver om dem. Sportsinteresserte Nichols begynte å plotte inn mengden av tweets om kampene under VM i fotball i 2010. Han så at mengden økte på visse tidspunkter, og brukte sin ad hoc-metode til å finne de mest spennende øyeblikkene i en kamp slik at han kunne spole fram til dem på sin videoopptaker. Mengden tweets øker naturlig ved spennende hendelser, særlig scoringer.

Deretter begynte Nichols og hans team å spørre vanskeligere spørsmål om hva slags oppsummeringer de faktisk kunne lage på bakgrunn av Twitter-materialet. De endte opp med å lage et system som kunne behandle alle tweets om en kamp, finne toppene i tweet-aktivitet, velge ut representative nøkkel-meldinger fra disse hendelsene, og spleise dem sammen til korte oppsummeringer. Når lesbarhet og grammatikalsk nivå ble sammenlignet, viste det seg at tekstene laget med algoritmen var av tilsvarende kvalitet som manuelt produserte oppsummeringer basert på det samme Twitter-materialet.

IBM-systemet viste likevel at en spesiell type skjevhet kan snike seg inn i algoritmer:

Enhver skjevhet i dataene som algoritmen fores med blir med på lasset helt fram til det ferdige resultatet. Algoritmen er partisk til fordel for “de som skriker høyest”, ifølge Nichols, siden den relativt enkle algoritmen finner relevante tweets ved å lete etter frekvensen av nøkkelord på engelsk. Implikasjonene er ganske klare: Hvis Slovenia scorer et kontroversielt mål mot USA, kan algoritmen rapportere at “USA ble ranet”, hvis det er den dominerende reaksjonen i engelskspråklige tweets. Men antakelig vil ikke slovenere som tvitrer om hendelsen være enig. De vil sannsynligvis melde noe sånt som “Fint mål — der fikk dere den, USA!” (på slovensk, selvfølgelig). Nichols er interessert i å tilpasse algoritmen for å ta hensyn til ulike perspektiver og generere bevisst partiske oppsummeringer fra ulike synsvinkler (kan bli en vinner i amerikanske kabel-tv-nyheter!).

Når de skal ta avgjørelser om hva som skal inkluderes i eller ekskluderes fra en oppsummering, må algoritmer vanligvis gå gjennom et skritt der informasjon prioriteres. Ting med lavere prioritet blir ekskludert. IBM-systemet er for eksempel rettet inn mot høydepunkter i idrettsbegivenheter. Dette fungerer hvis målet er å finne de mest spennende delene av en kamp, som får mye oppmerksomhet. Men det er andre interessante historier som bobler like under terskelen for “høydepunkter”. Hva med midtstopperen som spilte solid i forsvar, men aldri gjorde en enkeltprestasjon som ga mange nok tweets til å bli oppdaget av algoritmen? Denne delen av kampen, eller historien, ville bli utelatt.

IBM-algoritmen ikke bare prioriterer informasjon, men må også gjøre utvalg basert på ulike kriterier. Noen av disse valgene kan også kodes inn slik at programmererne hjelper algoritmen med å gjøre valg (heuristikk). For eksempel har IBM-systemets programmerere forhåndsbestemt at algoritmen skal foretrekke lengre framfor kortere tweets til oppsummeringene, siden de kortere meldingene pleier å være mindre lesbare setningsfragmenter. Det er helt klart en avgjørelse som kan forsvares, men Nichols innser at det også kan skape en skjevhet: “Å utelate kommentarer fra folk som har en tendens til ikke å skrive fullstendige setninger kan kanskje ekskludere en lavere utdannet del av befolkningen”. Kriterier valgt av programmerere for utvalg og prioritering kan korrelere med andre variabler (som utdanningsnivå) som kan være viktige når partiskhet og skjevheter i mediedekning skal vurderes.

Optimering, rangering, aggregering

Oppsummeringen er bare én type informasjonsbehandling som kan systematiseres i en algoritme. Din daglige nyhetsmeny har antakelig blitt påvirket av mange ulike algoritmer allerede før du har begynt å konsumere nyhetene. Algoritmer for personalisering som dem som brukes av Zite, en populær applikasjon for å lese nyheter, tilpasser systematisk innhold til dine interesser, på bekostning av å eksponere deg for et større mangfold av saker. Social Flow, en gründerbedrift i New York, bruker algoritmer for optimering for å finne ut det nøyaktige tidspunktet for når det er best å dele nyheter i sosiale nettverk slik at de får maksimalt gjennomslag hos målgruppen.

Optimeringsalgoritmer kan også bli brukt (pdf) til å bestemme layouten av en nyhetsside. Men å optimere layout basert på ett kriterium, som antall sidevisninger, kan ha utilsiktede konsekvenser, som at skandaler og kjendisnyheter alltid havner øverst på siden. Også her kan valget av hvilke aspekter man vil optimere og hva de er korrelert med, ha betydning.

Algoritmer for rangering er annen type som er mye brukt i nyhetssammenheng. Tenk på listene over “toppsaker” på de fleste nettaviser, eller hvordan kommentarer blir rangert, eller til og med på hvordan Twitter rangerer trender. Særlig Twitter-trender har kommet i søkelyset etter at hendelser som folk trodde ville dukke opp på listen over trender, som #occupywallstreet eller #wikileaks, ikke viste seg. I likhet med Summly er ikke Twitter åpne om algoritmen de bruker til å identifisere trender. Det gjør det vanskelig å vurdere hvilke systematiske skjevheter som er innebygd i algoritmen og om heuristikk eller menneskelige valg innlemmet i den også kan spille en rolle.

Forskere jobber med hvordan du kan bli eksponert for nyheter på en nyttig måte

Google bruker også rangeringsalgoritmer til å sortere søkeresultatene dine. I dette tilfelle er rangeringsalgoritmene utsatt for den samme typen skjevhet til fordel for “de som skriker høyest” som vi hørte om fra Nichols. Internett er fullt av firmaer spesialisert på søkemotoroptimalisering som prøver å lure Googles algoritme slik at visse typer innhold vil vises høyt oppe i søkeresultatene selv om det kanskje ikke fortjener å være der. Dette gjør de delvis ved å knytte visse nøkkelord til nettstedet de ønsker å dytte oppover på listen over søkeresultater, og ved å lage hyperlenker fra mange andre nettsteder til dette nettstedet. Andre prøver å manipulere søkerangeringer. Professor Takis Metaxis ved Wellesley College og hans kollega Eni Mustafaraj har skrevet om “googlebombing”. Her skaper man koblinger mellom politiske aktører, som George W. Bush, og negative søkeord, som “håpløs fiasko”, slik at personen dukker opp når noen søker på denne frasen. Dette er et perfekt eksempel på hvordan skjevheter i data som en algoritme fores med kan føre til skjevheter i resultatet. Og når dataene algoritmen fores med er offentlige, ligger algoritmen åpen for manipulasjon.

Ikke alle typer skjevheter og partiskhet i algoritmer må være skadelig. Hvis algoritmer kunne skape en motvekt til individuell og tankemessig partiskhet vi alle bærer i oss, kunne det ha en positiv effekt på informasjonen vi blir eksponert for. Ved Korea Advanced Institute of Science and Technology (KAIST) har Souneil Park og hans samarbeidspartnere eksperimentert med algoritmer for innsamling av nyheter som fores inn i en nyhetspresentasjon kalt NewsCube (pdf). Denne leder brukeren til å forholde seg til et større mangfold av perspektiver. Glem å overlate ting til tilfeldighetene — forskere jobber med hvordan du kan bli eksponert for nyheter på en nyttig måte. Richard Thaler og Cass Sunstein kaller i sin bok Nudge denne formen for innflytelse for “libertariansk paternalisme” — å påvirke erfaringer for å korrigere for kognitive mangler i menneskers resonneringsevne. Ikke bare kan algoritmer skape skjevheter i innholdet vi konsumerer — en dag kan de kanskje gjøre det på en måte som gjør oss smartere og mindre utsatt for våre egne tankemessige brister. En algoritme kunne kanskje til og med sakte dytte ekstremister mot midten ved å eksponere dem for stadig mer moderate versjoner av deres egne ideer.

Algoritmer finnes over alt i nyhetene som omgir oss, enten det er i oppsummeringer, personalisering, optimering, rangering, koblinger, klassifisering, aggregering eller en annen algoritmisk informasjonsprosess. De er allestedsnærværende, og det gjør det verdt å reflektere over hvordan disse prosessene kan bidra til systematisk manipulasjon av informasjonen vi konsumerer, enten det er gjennom heuristikk, dataene de fores med, eller kriteriene som brukes til å hjelpe dem med å ta beslutninger om å inkludere, ekskludere og vektlegge.

Algoritmer vil alltid måtte ta ikke-tilfeldige avgjørelser om inkludering, ekskludering og vektlegging i mediene våre for å hjelpe oss å løse vårt problem med knapp tid og oppmerksomhet. Vi kan ikke på magisk vis gjøre algoritmer “objektive” ved å forstå hvordan de forårsaker skjevheter i mediene. Men vi kan lære oss å bli mer kritiske når vi bruker databaserte medier. Særlig datajournalister burde gjøre det til en vane å tenke grundig over hva bivirkningene av algoritmene de lager kan være og hva som kan korrelere med kriteriene de bruker for å ta avgjørelser. I neste omgang bør vi være åpne om disse bivirkningene på en måte som hjelper publikum til å bedømme kvaliteten på det vi gjør.

Artikkelen ble først publisert av Nieman Journalism Lab. Oversatt av Olav Anders Øvrebø.