Tidligere i år publiserte BuzzFeed en video der den tidligere amerikanske presidenten Barack Obama liret av seg noen vittigheter langt utenfor hans sedvanlige karaktertrekk.

Det mest bemerkelsesverdige med videoklippet er imidlertid ikke det at Obama kom med slike uttalelser, men det at han faktisk ikke gjorde det. I stedet hadde stemmen til skuespiller Jordan Peele der han gir seg ut for å være Obama, gjennomgått en mediesyntesealgoritme som genererte videoen. Resultatet er forbløffende autentisk.

På nett er ingenting helt som det gir seg ut for å være, og nå enda mindre enn før. Takket være en ny type nevrale nettverk av maskinlæringsalgoritmer, kan overbevisende, men fiktive videoer, bilder, stemmer og tekst, syntetiseres fra bunnen av.

Datamaskiner kan lage virkelighetstro bilder av fiktive ansikter — med følelser, hud, alder og kjønn plottet inn via tastaturet. Stiloverføring kan endre et bildes omgivelser, og få vinter til å bli sommer, solfylt til regnfylt. Videoklipp av politikere kan lages på samme måte som en dukkefilm. Og ansikter kan byttes ut fra en kropp til en annen, kjent som “deepfakes”, noe som åpner opp for en rekke farer for rykte, sikkerhet og personvern. Ganske rystende greier.

Men på en måte kan dette teknologiske spranget faktisk være gode nyheter for journalister — og kan også være en anledning for teknologiplattformer til å vise velvilje overfor et mistenksomt publikum.

Teknologisk undergraving av sannhet

Joda, bilder har blitt manipulert mer eller mindre siden bildeteknologien ble oppfunnet. Og mediene selv er kun et bilde av en virkelighet, hvor alle utvalg, redigeringer, fremhevinger og formuleringer former publikums tolkning av hendelser og begivenheter.

TEKNOLOGIBLOGGEN

Dette innlegget publiseres som del av den nye Teknologibloggen på Vox Publica. Les mer om hva vi planlegger på bloggen framover.

Det nye her er at mediesyntesealgoritmer bryter enda mer ned vår forventning om autentisiteten til innspilt media som foto, video og lyd, og samtidig muliggjør en ny og mer omfattende inngripen, personliggjøring og enklere bruk for alle — fra skuespillere til spioner. Konstruerte videoer kan rokke ved og endre menneskers dannelse av faktiske minner av hendelser. Og visuelle bevis kan i stor grad miste sin rolle når strategiske desinformatører bruker hele det teknologiske spekteret til å undergrave enhver sannhet.

Så hva skjer når folk ikke lenger kan stole på nettmedier? Hvordan kan et samfunn ha en opplyst forståelse av det som skjer i verden når mediene såpass enkelt kan bli infiltrert av mediesyntesealgoritmer?

Dystert som det kan se ut, kan dette være en gyllen mulighet for de etablerte medienes comeback. Når publikum lærer at man ikke lenger kan stole på det de serveres på nett, er det få andre enn profesjonelt opplærte journalister med tilgang til avanserte undersøkelsesverktøy som kan innta rollen som kvalitetssikrere og faktasjekkere. Skal de gripe sjansen, bør journalister og nyhetsorganisasjoner satse på strategier som opplæring i undersøkende journalistikk, utvikling av tekniske verktøy, samt standardiserte og transparente prosesser.

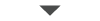

Avansert faktasjekk: FaceForensics bruker maskinlæring for å avgjøre om en video av et ansikt er ekte. (Foto: Skjermbilde FaceForensics/Youtube).

Nyhetsorganisasjoner og utdanningsinstitusjoner må komme i gang med opplæring i teknikker innen medieundersøkelse (media forensics). Det er avslørende tegn ved endret og syntetisert media som et trent øye kan legge merke til — noe Hany Farids bok om bildeundersøkelser gir et par eksempler på. Statistisk analyse av fargepiksler, intensitet og deres regelmessighet kan vise tegn på bilderedigering eller bildesplicing; refleksjoner og flytpunkter kan vise geometriske avvik; og både sensorstøv og kompresjonsartefakter kan også være avslørende. I videoklipp kan munnen til syntetiserte ansikter noen ganger flimre eller se unaturlig ut; øynene kan ha et drag over seg som hos zombier. Algoritmene er ikke perfekte, men journalister, i likhet med andre etterforskere, må ha trente øyne for å oppdage feilene.

Utviklingen og integrasjonen av datastøttete undersøkelsesverktøy vil være like viktig som opplæring i medieundersøkelse. Selv om syntetisert innhold av og til kan lure det menneskelige øyet, kan det statistiske øyet til en undersøkende algoritme vite at det er forfalsket.

Verktøy for medieverifisering

Et nylig forskningsprosjekt kalt FaceForensics bruker maskinlæring til å se om en video av et ansikt er ekte, med 98,1 prosent nøyaktighet. En annen metode ser etter blodstrømmen i videoklipp av en persons ansikt for å se om pikslene blir regelmessig rødere når hjertet pumper blod.

Det amerikanske forvaltningsorganet National Institute of Standards and Technology (NIST) oppfordrer til mer forskning på området med deres Media Forensics Challenge, og det publiseres faktisk årlig hundrevis av forskningsartikler om digitale undersøkelser.

Det er imidlertid et stykke igjen før denne teknologien er billig nok til allmenn bruk og dermed praktisk i journalistikken. Selv om det finnes noen få integrerte verktøy, som InVid som bidrar til medieverifisering, er de fleste datastøttete undersøkelsesmetoder fremdeles prototyper i forskning og langt fra tilgjengelig i den daglige journalistiske arbeidshverdagen. Her trengs det mer utprøving i praksis.

Det er dessuten viktig at andre enn bare nyhetsorganisasjoner holder et øye med falskt videomateriale. Noen av de andre berørte har egne forskningsmidler, for ikke å glemme dype lommer: Informasjonsplattformer som ofte ender opp med å være vert for syntetisert media kan bidra til denne nødvendige utprøvingen. Hvis Facebook og YouTube for eksempel integrerte FaceForensics-algoritmen, ville de kunne flagge og tydelig merke videoer mistenkt for å være falske. Det ville være nok et signal til brukerne og mediene om å være oppmerksom på videoens autentisitet, og det ville kunne være en måte for teknologiplattformer å vise vilje til å handle til samfunnets beste, i stedet for kun å gå etter kortsiktig økonomisk vinning.

LES OGSÅ:

Eirik Stavelin om faktisk.no og fremtiden for faktasjekking.

For å bygge opp denne sårt trengte tilliten, ville plattformene også måtte være åpne om hva denne slags “autentisering” innebar. Hvis denne prosessen var integrert i for eksempel YouTubes filter for begrenset innhold, ville sluttbrukerne kunne kontrollere hvorvidt flaggete videoer skal automatisk skjules eller ei. Og hvis teknologiske selskaper gjorde algoritmer for medieverifisering gratis tilgjengelig via API-er, kunne datajournalister integrere verifiseringssignaler i arbeidsflyten slik de selv ønsket, mye av det samme som gjøres i dag for trivielle oppgaver som geokoding av gateadresser i breddegrader og lengdegrader.

Kontekstens betydning for autentisitet

Men teknikker innen medieundersøkelse kan likevel kun hjelpe oss et stykke på vei. De kan være vanskelige å bruke, kreve mye opplæring for å kunne tolke, er ofte heller ikke absolutte, og — som enhver form for informasjonssikkerhet — vil trenge konstant og vedvarende teknisk støtte og oppsyn.

En annen gren innen undersøkelsesmetoder ser på mediekontekst for å avgjøre autentisitet: Hvis et bilde lett kan syntetiseres, vil metadata om tidspunkt, sted, sosial setting eller annen kontekst bli desto viktigere for en reell verifisering. Hvis et mistenkelig interessant bilde er lastet opp av en konto opprettet dagen før og har det som ser ut til å være en horde av bot-følgere, er dette nok en faktor å ta med i beregningen. Å tolke kontekst for å støtte verifisering er en ny form for kompetanse innen medieforståelse der journalister, nok en gang, vil trenge opplæring, ekspertise og verktøy som bidrar til å få noe ut av den store skyen av kontekst.

På samme måte som verifiseringsprosedyrer for sosiale medier er systematisert og tatt i bruk av organisasjoner som Storyful og Bellingcat — som følger rigide prosedyrer for å triangulere, bekrefte og underbygge innhold og dets opphavssted -, må journalister utvide og kode arbeidsflyten for å vurdere hvorvidt et bilde, en video eller tekst er resultatet fra en eller annen mediesyntesealgoritme. Nyhetsorganisasjoner burde gå hardere inn for transparente metoder. Robuste og standardiserte prosesser for verifisering og utrensking av syntetisert media må utvikles og publiseres åpent. Deretter må nyhetsorganisasjoner offentlig forplikte seg til å følge disse standardene. Det handler om tillit. Folk vil kanskje strømme til de mediene de vet følger nøyaktige og omfattende prosedyrer.

Artikkelen er oversatt fra engelsk av Camilla Skogseth Clausen.

Hvis vi ikke kan stole på det vi ser på nett, kan vi kanskje ha tillit til at et mediehus følger en rigid prosess for å sikre at det de publiserer er autentisk. Syntetisert media kan da være akkurat det som fører publikum tilbake i armene til de etablerte nyhetsorganisasjonene.